前言

Krita是一款开源跨平台的绘画软件

Krita通过插件与ComfyUI进行结合后 使得Krita的功能如虎添翼

关于ComfyUI的介绍以及安装使用 可参见之前文章《基于StableDiffusion的AI绘图应用ComfyUI》和《Mac平台部署AI绘图应用ComfyUI》 这里就不做重复介绍了

至于Krita的下载安装 可进入它的官网或者Github 获取最新的版本

Krita官网 : 点击进入

GitHub : 点击进入

本文主要聊一聊如何实现两者的结合

实现步骤

下载

krita-ai-diffusion插件

安装

krita-ai-diffusion插件打开

Krita应用 点击菜单栏中工具-->脚本-->从文件导入python插件

选择上一步下载好的插件压缩包 然后会弹出一个确认框 我们点击

yes选项:

开启插件面板

插件安装完成后 需要重启

Krita才能生效然后我们点击菜单栏中

设置-->面板列表-->AI image generation开启显示插件面板

此时我们在软件右下方可以看到插件面板:

安装

krita-ai-diffusion所需的ComfyUI插件保持

ComfyUI后台启动状态 然后点击configure打开插件设置面板 在Connection选项中勾选Custom Server也就是使用ComfyUI服务:

这里报错 提示我们需要安装额外的五个依赖插件 并且暖心地给我们提供了插件的下载地址😬

- ControlNet Preprocessors https://github.com/Fannovel16/comfyui_controlnet_aux

- IP-Adapter https://github.com/cubiq/ComfyUI_IPAdapter_plus

- Ultimate SD Upscale https://github.com/Acly/krita-ai-diffusion/releases/download/v0.1.0/ComfyUI_UltimateSDUpscale-6ea48202a76ccf5904ddfa85f826efa80dd50520-repack.zip

- External Tooling Nodes https://github.com/Acly/comfyui-tooling-nodes

- Inpaint Nodes https://github.com/Acly/comfyui-inpaint-nodes

插件下载好后 将插件

zip包解压后放入ComfyUI名为custom_nodes的插件目录下安装

ComfyUI插件的依赖ComfyUI插件都是用python编程的库 这些个插件内部有自己的python库依赖 我们需要进行安装1

2

3pip3 install opencv-python

pip3 install matplotlib

pip3 install skimage

安装所需模型

当我们插件安装完毕 重启

ComfyUI和Krita此时又有新的提示:

缺少相应的模型 我们需要进行下载 官方提供的链接是

Huggingface下载点 国内访问速度非常慢这里推荐大家使用Huggingface 镜像站 需要下载的模型有以下几个 体积总共5个多GB:

这里我已经把下载链接替换成了镜像站的连接 直接点击即可下载:

- Clip-Vision to

models/clip_vision/SD1.5 - NMKD Superscale SP_178000_G to

models/upscale_models - OmniSR_X2_DIV2K to

models/upscale_models - OmniSR_X3_DIV2K to

models/upscale_models - OmniSR_X4_DIV2K to

models/upscale_models - MAT_Places512_G_fp16 to

models/inpaint - ControlNet inpaint to

models/controlnet - ControlNet tile to

models/controlnet - IP-Adapter (SD1.5) to

models/ipadapter - LCM-LoRA (SD1.5) to

models/loras/lcm-lora-sdv1-5.safetensors这个模型下载后需要将文件名改为lcm-lora-sdv1-5.safetensors - DreamShaper to

models/checkpoint

- Clip-Vision to

重启

ComfyUI和Krita将插件和模型下载完毕 然后移动到对应的目录之后 重启应用 记住启动

ComfyUI后再启动Krita然后我们 会在

Krita右侧插件面板上看到连接成功字样:

指定

checkpoint模型我们在

Configure Image Diffusion配置窗口的Styles选项栏中 使用默认的New Style风格预设 并选择刚刚我们下载的DreamShaper模型:

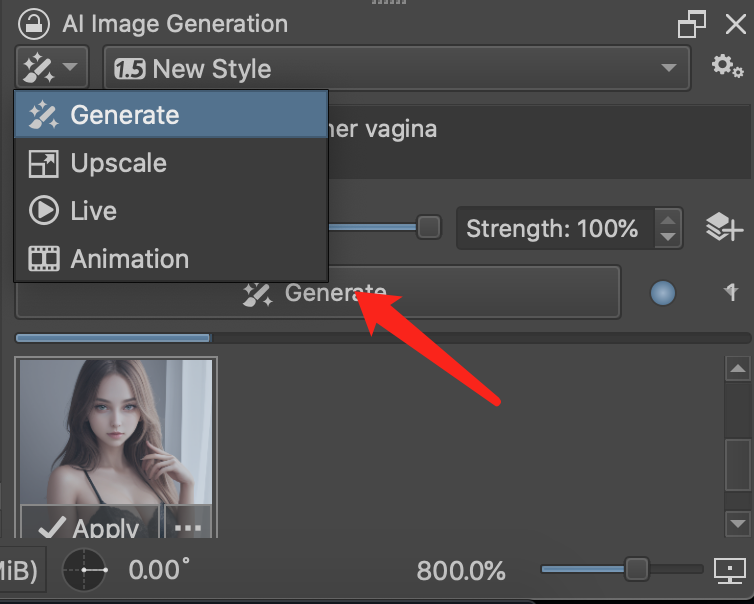

开始生成

在插件面板中输入相应的关键字 然后点击

generate开始生成

生成的图片如下:

咳咳 生成的效果很好 很满意😏

我们可以将生成的图片保存到本地 图片默认存放在当前工程同级目录下

除此之外 我们也可尝试其他的不同的风格 比如Cinematic Photo 偏现实风格, 别忘了在Styles配置选项中 指定我们下载的模型:

效果如下:

老司机们 还等什么呢🤣🤣

实时绘画

krita-ai-diffusion的强大不止于此 除了根据提示词生成图片之外 还可以实现对图片进行缩放、实时绘画和动画生成:

这里以实时绘画为例 做一个简单的介绍

只需要切换到Live功能 然后填入我们需要实时生成画面的物体关键字 比如蓝天、白云、一个女孩、山峰等等 这里需要填入英文:

Blue sky, white clouds, a girl, a mountain peak

然后新建颜料图层 用不同颜色绘制一个大概的框架

接着点击播放按钮 开启实时预览

通过调整Strength强度值来得到一个满意的雏形画面

当我们在画布上添加颜料时 插件面板会实时更新生成的画面

相关问题

面板列表中找不到

AI image generation这种情况一般是

Krita版本过旧导致的 需要更新最新版本 至少5.2.2以上版本才支持这个插件krita-ai-diffusion插件使用过程中报错Error while deserializing header: HeaderTooLarge

这种问题大概率出在

ControlNet模型, 建议更换模型不同模型擅长的风格不一样 有的写实风格更强 有的动漫风格更出色 针对不同的风格 我们可以选择不同的模型进行生成以获得更加满意的效果 比如可以尝试用一用下面两种

checkpoint模型

附加

《47个高质量 Stable Diffusion 常用模型推荐》

本文为作者原创 转载时请注明出处 谢谢